人工智能的专家级图像分析可以建立在有缺陷的理论基础上:研究

2024-07-29

来源: drugdu

245

245

简讯一览

简讯一览

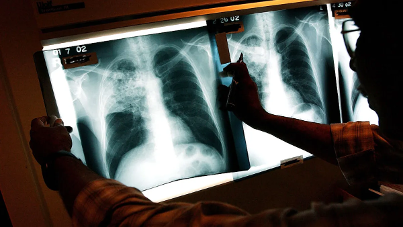

最近的一项研究表明,ChatGPT的一个版本可以在专家级别分析医学图像,但经常以不正确的推理得出正确的答案。

周二发表在同行评审期刊《npj数字医学》上的研究结果表明,OpenAI的人工智能GPT-4具有视觉能力,与缺乏外部资源的医生一样擅长回答有关医学图像的多项选择题。

然而,该模型在图像理解方面犯了错误,但仍有27%的时间达到了正确答案。研究人员表示,这些错误表明,在将人工智能模型集成到临床工作流程之前,需要进一步研究。

事件洞悉

GPT-4 with vision,称为GPT-4V,是ChatGPT大型语言模型的一个版本,可以同时分析图像和文本。试点医学研究发现,该模型在封闭式账簿环境中的表现优于医学生和医生。然而,根据这项新的研究,这些研究着眼于模型提供的答案,而没有评估它是如何得出结论的。

为了理解该模型答案的基本原理,美国国立卫生研究院的科学家要求一名高级医学生GPT-4V和来自不同专业的九名医生回答207道多项选择题。GPT-4V的提示规定,模型应包括图像的描述、相关医学知识的总结和答案的逐步推理。

没有外部工具(如文献搜索引擎)的医生正确回答了77.8%的问题。GPT-4V的正确率为81.6%。研究人员指出,模型的准确性与医生之间的差异在统计学上并不显著。

当医生能够获得外部资源时,他们的表现更好,对95.2%的问题给出了正确答案。在研究人员归类为困难的三分之一问题中,人类相对于模型的优势最为明显。

美国国立卫生研究院国家医学图书馆代理主任Stephen Sherry在一份声明中表示:“将人工智能整合到医疗保健中,作为一种帮助医疗专业人员更快地诊断患者的工具,使他们能够更快地开始治疗,前景广阔。”。“然而,正如这项研究所表明的那样,人工智能还不够先进,无法取代人类经验,而人类经验对于准确诊断至关重要。”

医生在闭式书本设置中未能回答46个问题,在开卷设置中未回答10个问题。GPT-4V正确回答了医生在两种情况下都出错的至少70%的问题。

研究人员表示:“这表明GPT-4V在为医生提供决策支持方面具有潜力。”。作者说,该模型在决策支持中的价值体现在一个所有人类群体都回答错误的问题上,“但GPT-4V成功地推断出舌溃疡是巨细胞动脉炎其他表现背景下的一种罕见并发症。”。

尽管如此,该模型提供的理由引起了人们的担忧。在一个响应中,该模型正确地识别了恶性梅毒,但未能识别出两个皮肤病变是由同一病理引起的。这是许多图像理解错误之一。

知识回忆和推理中的错误较为罕见,每次发生的概率约为10%。研究人员表示,该模型可能“在逻辑上不完整,但猜测正确”,并给出的答案“表明GPT-4V在区分类似的医疗状况表现方面的无能”

“了解这项技术的风险和局限性对于发挥其在医学上的潜力至关重要,”NLM高级研究员、该研究的作者陆志勇表示。

来源:

https://www.medtechdive.com/news/ai-image-analysis-flawed-rationales-nih-study/722355/

相关News

- 苑东生物EP-0210单抗注射液I期临床试验完成首例受试者给药 2026-02-10

- 智飞生物:重组带状疱疹ZFA01佐剂疫苗(CHO细胞)临床试验获批 2026-02-10

- 和誉医药FGFR4抑制剂依帕戈替尼获FDA快速通道资格,用于经ICI和mTKI治疗且FGF19过表达的晚期HCC患者 2026-02-10

- 赛诺菲「Rilzabrutinib」获美国突破疗法 + 日本孤儿药,中国已申请上市 2026-02-10

- 国产重磅 ADC 新适应症获批上市 2026-02-10

您已成功订阅,无需重复提交。

确认

邮件订阅

请输入正确邮箱!

订阅

邮件订阅热门医贸资讯,了解第一手信息。

行业动态更多

-

苑东生物EP-0210单抗注射液I期临床试验完成首例受试者给药

2026-02-10 -

智飞生物:重组带状疱疹ZFA01佐剂疫苗(CHO细胞)临床试验获批

2026-02-10 -

赛诺菲「Rilzabrutinib」获美国突破疗法 + 日本孤儿药,中国已申请上市

2026-02-10